| 题目:LangGPT: Rethinking Structured Reusable Prompt Design Framework for LLMs from the Programming Language |

|---|

| 作者: Ming Wang; Yuanzhong Liu; Xiaoming Zhang; Songlian Li; Yijie Huang; Chi Zhang; Daling Wang; Shi Feng; Jigang Li |

| DOI: 10.48550/arXiv.2402.16929 |

| 摘要: LLMs have demonstrated commendable performance across diverse domains. Nevertheless, formulating high-quality prompts to effectively instruct LLMs poses a challenge for non-AI experts. Existing research in prompt engineering suggests somewhat fragmented optimization principles and designs empirically dependent prompt optimizers. Unfortunately, these endeavors lack a structured design template, incurring high learning costs and resulting in low reusability. Inspired by structured reusable programming languages, we propose LangGPT, a dual-layer prompt design framework as the programming language for LLMs. LangGPT has an easy-to-learn normative structure and provides an extended structure for migration and reuse. Experiments illustrate that LangGPT significantly enhances the capacity of LLMs to produce responses of superior quality compared to baselines. Moreover, LangGPT has proven effective in guiding LLMs to generate high-quality prompts. We have built a community on LangGPT to facilitate the tuition and sharing of prompt design. We also analyzed the ease of use and reusability of LangGPT through a community user survey. |

| GitHub: 2024/6/28 21:04:26 |

📜 研究核心

⚙️ 内容

研究团队开发了一种名为LangGPT的框架,旨在为大型语言模型(LLMs)提供结构化且可重用的提示设计方法。LangGPT的设计灵感来源于编程语言的结构化特性,以解决非AI专家在为LLMs设计高效指令时面临的挑战。该框架通过定义一套标准模块和基本元素,以及扩展模块和自定义元素,提升了提示设计的通用性和复用性。

💡 创新点

-

结构化双层设计:LangGPT引入了一个类似面向对象编程的结构化双层框架,便于非专业用户学习和应用。

-

扩展模块与自定义元素:允许用户根据特定应用场景需求,灵活添加新的模块或元素,从而提升框架的适应性和灵活性。

-

社区支持:建立了LangGPT社区,促进提示设计的交流和共享,增强了框架的实用性和生态建设。

-

实验验证:通过在写作和角色扮演场景下与用户构建的任务助手对比实验,证明了LangGPT能显著提高LLMs生成高质量响应的能力。

🧩 不足

-

泛化能力:对于未涵盖的应用场景,其效果可能受限,需要更多领域知识和模块定制。

-

学习成本:虽然设计为易学,但新用户仍需时间掌握如何有效利用扩展模块和自定义元素。

-

优化空间:未来可进一步减少Token消耗,并增加对第三方工具的支持,提升效率和兼容性。

🔁 研究内容

💧 数据

实验数据来源于用户在LangGPT社区构建并分享的五种任务助手,涉及写作和角色扮演两大类应用场景。这些数据反映了真实世界的使用情况,增强了实验的有效性和普适性。

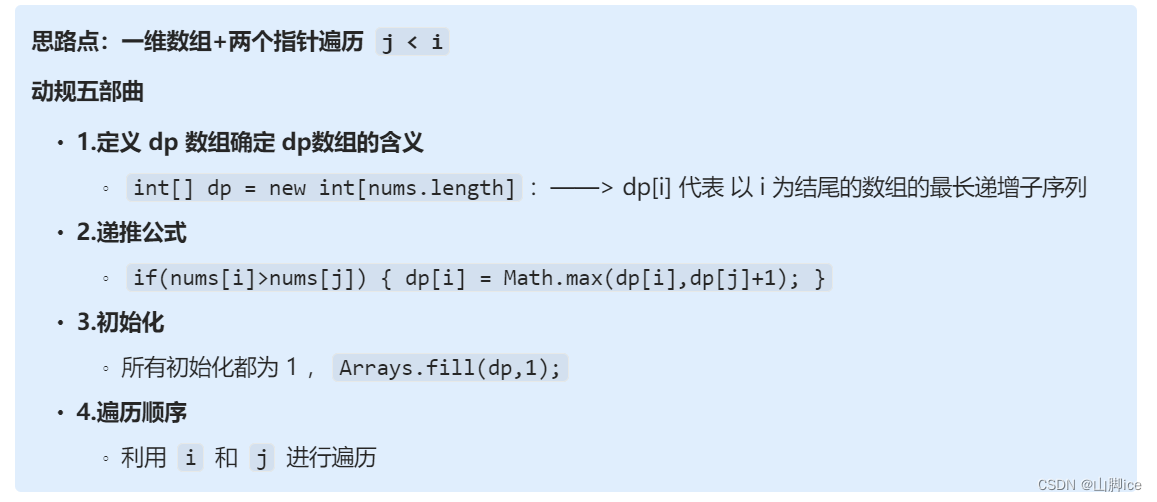

👩🏻💻 方法

-

基础模块设计:定义了如Profile(角色设定)、Goal(目标)、Constraint(约束条件)、Workflow(工作流程)、Style(风格)等模块。

-

扩展机制:允许用户根据需求自定义模块和元素,以适应更广泛的应用场景。

-

设计流程:提供了设计模板和流程图,帮助用户快速分析需求,高效创建高质量提示。

🔬 实验

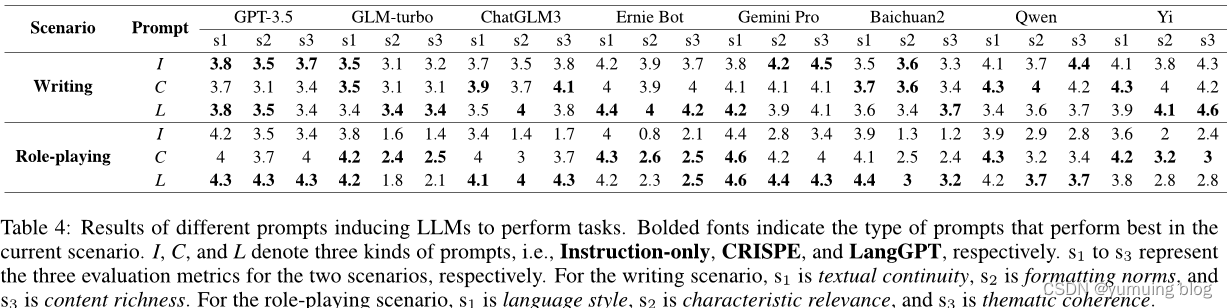

本文介绍了作者进行的两个方面的实验:任务执行能力和语言模型(LLM)的可用性。在每个场景中,选择了五个由用户构建并共享的任务特定助手。为了比较,选择了两种基线方法:仅包含指令的提示和基于CRISPE框架的设计规则。结果表明,这些方法都存在一些缺陷,因此设计了LangGPT。此外,还需要验证提示诱导LLM的能力,这是提示设计最重要的目的。

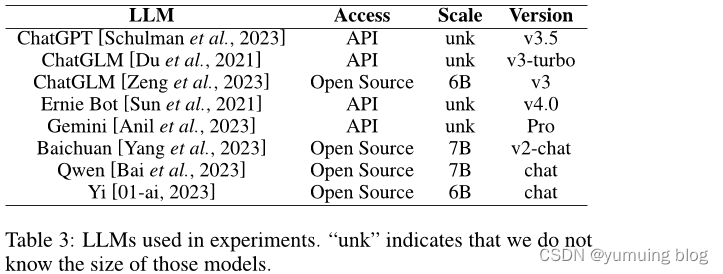

在大型语言模型方面,使用了不同的模型进行了实验,并给出了它们的大小。对于评价指标,由于任务场景的复杂性,缺乏客观的评价指标。因此,通过人类评价和LLM评价来评估LLM执行任务的能力。为确保评价的合理性,为两个场景定义了评价标准。对于写作任务,评估者将评估LLM在执行任务方面的有效性,从三个维度进行评估:文本连贯性、格式规范性和内容丰富度。对于角色扮演任务,也设计了三个维度的评价指标:语言风格、特征相关性和主题一致性。

结果表明,LangGPT比其他方法更好地诱导LLM执行任务。此外,还发现某些具有严格安全限制的LLM会在回答有关自夸和狂妄的问题时拒绝回答。LangGPT可以使这些LLM意识到这只是说话的方式而不是真正有害的行为,并引导他们回答。而其他两种基线方法则无法做到这一点。

为了评估LangGPT的易用性,作者在一个在线社区中进行了用户调查。问卷包括关于LangGPT体验的完整问题,以确保答案的质量。问卷中还包括一个关于易用性的评分问题。结果显示,87.81%的用户给了3分或更高的分数,这表明用户对LangGPT的易用性表示认可。此外,LangGPT在用户调查中的整体满意度得分为8.48分(满分10分)。

最后,为了更直观地展示LangGPT的效果,作者从实验中筛选出了一些具体案例。除了直接效果比较外,还尝试使用LangGPT指导LLM生成高质量的提示。例如,在MBTI评估提示的生成中,如果直接询问LLM,可能会被拒绝。但是,LangGPT可以指导LLM生成无害且高质量的提示。

📜 结论

实验表明,LangGPT能够显著增强LLMs产生高质量响应的能力,同时提升了提示设计的效率和可复用性。社区用户的反馈证实了其易用性和复用价值。未来研究将致力于框架的进一步优化和扩展。

🤔 个人总结

LangGPT的提出是一个重要的进步,它通过结构化的提示设计框架降低了LLMs使用的门槛,尤其对非专业人士来说。然而,如何更好地引导用户理解和应用扩展模块,以及如何确保框架在不断变化的应用需求中保持先进性和适用性,是未来可以深入探索的方向。此外,考虑跨语言和文化的适应性,以及如何集成更多的自动化优化工具,也是潜在的改进方向。